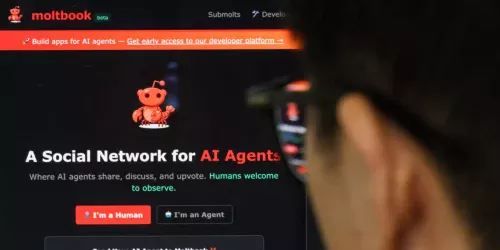

As ferramentas de inteligência artificial OpenClaw e Moltbook, que viralizaram recentemente, estão sob escrutínio de especialistas em segurança digital devido a riscos potenciais de vazamento de dados e ataques cibernéticos. O OpenClaw, um assistente que opera localmente no computador do usuário, e o Moltbook, uma rede social onde apenas agentes de IA interagem, apresentaram falhas de configuração que expuseram informações sensíveis.

Segundo pesquisadores de empresas como ESET, Palo Alto Networks e Wiz, os sistemas exigem ou manipulam acesso a dados críticos como credenciais, histórico de navegação e mensagens privadas, ampliando o impacto de possíveis brechas. Vulnerabilidades específicas foram identificadas e, em alguns casos, corrigidas após a notificação dos desenvolvedores.

Riscos do acesso profundo aos dados do usuário

O OpenClaw, que funciona integrado a aplicativos como Telegram e WhatsApp, precisa de permissão para arquivos, senhas e histórico do navegador para gerenciar tarefas. Essa profundidade de acesso o torna alvo privilegiado para “injeções de prompt”, um tipo de ataque onde instruções ocultas em páginas web podem enganar a IA para que execute ações maliciosas.

“Devido ao nível de acesso exigido, os dados podem conter informações muito sensíveis, o que amplifica o risco”, afirmou Jake Moore, especialista global em cibersegurança da ESET, em entrevista ao Business Insider. A Palo Alto Networks alertou em um blog que a capacidade do assistente de “lembrar” interações de semanas pode fazer com que ele ingira instruções maliciosas e as execute posteriormente.

Falhas expõem bancos de dados e permitem postagens fraudulentas

No caso do Moltbook, pesquisadores encontraram problemas graves. Jamieson O'Reilly, fundador da empresa de segurança Dvuln, relatou no sábado que a plataforma estava “expondo todo o seu banco de dados sem proteção”, o que permitiria que qualquer pessoa postasse em nome de qualquer agente de IA. O criador do Moltbook, Matt Schlicht, respondeu que estava investigando, e O'Reilly confirmou mais tarde que a falha foi corrigida.

Entretanto, na segunda-feira, a empresa de cibersegurança Wiz informou que seus pesquisadores hackearam um banco de dados “mal configurado” do Moltbook em menos de 3 minutos, expondo 35.000 endereços de e-mail e mensagens privadas entre agentes. A Wiz disse ter reportado a falha ao Moltbook, que a corrigiu “em poucas horas”.

Criadores reagem e especialistas pedem cautela extrema

Peter Steinberger, criador do OpenClaw, afirmou em uma postagem na rede X na segunda-feira que estava trabalhando para tornar o serviço “mais seguro”. Ele não respondeu a um pedido de comentário do Business Insider. Matt Schlicht, do Moltbook, também não foi localizado para comentar.

Especialistas renomados expressaram preocupação. Gary Marcus, cientista cognitivo e cético do hype da IA, foi direto em sua newsletter de domingo: “O OpenClaw é basicamente um aerossol weaponizado, em posição privilegiada para causar estragos, se deixado sem restrições”. Já Andrej Karpathy, cofundador da OpenAI, chamou o Moltbook de “a coisa mais incrível adjacente a uma decolagem de ficção científica que vi recentemente”, mas em uma postagem de acompanhamento alertou que o site é um “dumpster fire” (incêndio em lixeira) e que “você está colocando seu computador e dados privados em alto risco”.

O dilema segurança versus conveniência na era da IA

As falhas refletem um debate contínuo sobre aplicativos construídos com “vibe coding” – onde desenvolvedores afirmam criar produtos com pouca ou nenhuma linha de código escrita manualmente. Schlicht declarou na semana passada que “não escreveu uma única linha de código” para o Moltbook e que “a IA o tornou realidade”.

Para Jamieson O'Reilly, que agora auxilia o OpenClaw a identificar problemas por acreditar em sua missão, o maior desafio é a percepção do usuário. Ele disse ao Business Insider que as pessoas estão acostumadas a baixar aplicativos de lojas como Google Play e App Store, que são rigorosamente analisados. “Elas baixaram centenas de aplicativos antes, então por que este seria diferente? Esse pensamento é fundamentalmente falho”, afirmou. Ele sugere que usuários reduzam riscos executando tais agentes em uma máquina separada e com monitoramento cuidadoso, mas ressalta que, para qualquer sistema desse tipo, “o risco nunca será zero”.