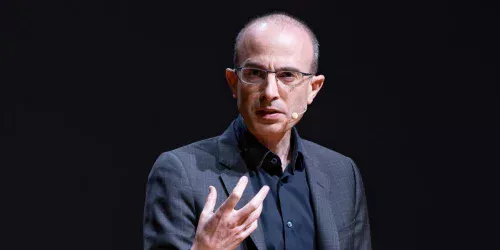

O historiador e autor best-seller Yuval Noah Harari fez um alerta contundente sobre os riscos da inteligência artificial durante o Fórum Econômico Mundial em Davos, na Suíça. Em sua fala na terça-feira, ele argumentou que o mundo está subestimando gravemente a escala de tempo necessária para entender o verdadeiro impacto da tecnologia, que deve se desdobrar ao longo de 200 anos, e não em décadas.

Harari, autor de "Sapiens: Uma Breve História da Humanidade", criticou a visão de curto prazo predominante nos debates. "Muitas das conversas aqui em Davos, quando dizem 'longo prazo', significam algo como dois anos", disse. "Quando eu quero dizer longo prazo, penso em 200 anos."

Comparação com a Revolução Industrial

O pensador comparou o momento atual da IA aos primórdios da Revolução Industrial. Segundo ele, a humanidade tende a malinterpretar tecnologias transformadoras enquanto elas se desenvolvem. As consequências mais profundas da industrialização levaram gerações para emergir completamente, frequentemente através de convulsões sociais, políticas e geopolíticas imprevisíveis.

"Você pode testar por acidentes", afirmou Harari. "Mas você não pode testar as implicações geopolíticas ou culturais da máquina a vapor em um laboratório. É o mesmo com a IA."

Efeitos de longo prazo já em movimento

O historiador alertou que, mesmo que o desenvolvimento da IA parasse hoje, seus efeitos de longo prazo ainda seriam impossíveis de compreender. "A pedra foi jogada na piscina, mas ela acabou de atingir a água", ilustrou. "Não temos ideia de quais ondas foram criadas, mesmo pelas IAs que foram implantadas um ou dois anos atrás."

Harari se junta a uma série de pesquisadores seniores e líderes de tecnologia que expressaram preocupações com os riscos da IA, que variam desde ondas de desemprego até a extinção humana.

Preocupação com a complacência

No entanto, o que mais preocupa Harari não é apenas a incerteza, mas a complacência. Ele afirmou que muitos dos tomadores de decisão mais poderosos que moldam a IA estão focados em incentivos de curto prazo, em vez de consequências de longo prazo.

"Estou principalmente preocupado com a falta de preocupação de que estamos criando a tecnologia mais poderosa da história humana", declarou.

"Pessoas muito inteligentes e poderosas estão preocupadas com o que seus investidores dirão no próximo relatório trimestral", criticou Harari. "Elas pensam em termos de alguns meses, ou um ano ou dois."

As consequências sociais da IA, segundo ele, se desdobrarão muito além desse horizonte – quer o mundo esteja preparado ou não.